Cet article a été initialement publié le 11 décembre 2018 sur le site Digital Society Forum

C’est un sujet qui revient régulièrement dans la presse tech américaine : les biais des algorithmes qui pénalisent les Afro-Américains.

Les biais racistes et sexistes des algorithmes

En 2016, le site d’investigation ProPublica a mené une grande enquête sur les biais du logiciel COMPAS, utilisé pour prédire les risques de récidive, et conclu que ce logiciel était “biaisé contre les Noirs”. Pas explicitement – mais parce qu’il prenait en compte des variables fortement corrélées à la « race » (entendue non comme réalité biologique mais construction sociale), dans une société où il existe de fortes différences économiques, sociales etc. entre la communauté afro-américaine et la communauté blanche. Cette discrimination par la machine est un exemple de "biais algorithmique" : malgré le désir d’impartialité des concepteurs de l’algorithme, celui-ci va refléter des orientations particulières ou des discriminations existantes (qui peuvent se trouver dans les données sur lesquelles l’algorithme est entraîné, par exemple). Ces dernières années, les exemples de biais racistes ou sexistes se multiplient : ainsi le logiciel de Google Photos qui étiquetait comme des « gorilles » deux Afro-Américains , des distributeurs de savon automatique qui ne réagissent pas aux peaux noires ou encore récemment un outil d’aide au recrutement utilisé par Amazon et défavorisant les femmes, abandonné depuis…

Le tweet d'un utilisateur découvrant ses amis étiquetés comme des "gorilles" par la reconnaissance automatique d'images de Google

Un article passionnant paru dans le magazine américain « Logic » se penche en profondeur sur la question des biais dans les logiciels d’intelligence artificielle de reconnaissance faciale. L’article s’intitule « White code, black faces » , ce qu'on pourrait traduire par « Peaux noires, code blanc », pour conserver la référence à l’auteur anticolonialiste Franz Fanon .

La double peine

L’article commence par raconter une arrestation banale en Floride. Pour le coincer, deux détectives en civil achètent de la drogue à un dealer. Ils ne savent ni son nom ni son adresse : ils n'ont pour le retrouver qu'une photo prise à la dérobée sur leur téléphone. De retour au poste, ils l'analysent avec un logiciel de reconnaissance faciale. Bingo : celle-ci livre un nom. L'arrestation s'ensuit rapidement, sans autre élément de preuve que l'identification fournie par le logiciel.

Or, explique le journaliste Ali Breland , l'auteur de l'article, la technologie de l’identification par reconnaissance faciale est loin de faire l’unanimité chez les scientifiques. Interviewée, Clare Garvie, chercheuse à l’université de Georgetown et directrice d’un projet de recherche portant sur l’efficacité des logiciels de reconnaissance faciale , rappelle qu’il n’existe pas de consensus au sein de la communauté scientifique sur l’efficacité de ces outils. L'étude qu'elle a dirigée rappelle : "Nous savons très peu de choses sur ces systèmes. Nous ignorons leur effet sur la vie privée et les libertés individuelles. Nous ignorons comment ils peuvent garantir la justesse de leurs résultats. Et nous ignorons comment ces systèmes -- à l'échelle locale, à l'échelle de l'Etat ou à l'échelle fédérale -- affectent les minorités raciales et ethniques".

Car plusieurs travaux montrent que ces logiciels sont biaisés envers les personnes de couleur. L'étude citée plus haut soulignait que les personnes noires étaient plus susceptibles d’être passées au crible de la reconnaissance faciale lors des enquêtes et que le logiciel était plus susceptible de se tromper lorsqu’il s’appliquait à des personnes noires. Une forme de double peine, comme le résumait un membre d’une commission sénatoriale lors d’une audience sur l’efficacité des logiciels de reconnaissance faciale : « Si vous êtes Noir, vous avez plus de chances que cette technologie s’applique à votre cas, et plus de chances qu’elle produise des résultats faux. »

Des logiciels entraînés sur des bases de données blanches

Ce qui est en cause, estime Ali Breland, c’est le manque de diversité dans le secteur de la technologie, qui produit « un code racialisé ». Il cite les travaux de Joy Buolamwini , chercheuse au MIT Media Lab , qui travaille sur les biais de couleur dans les algorithmes.

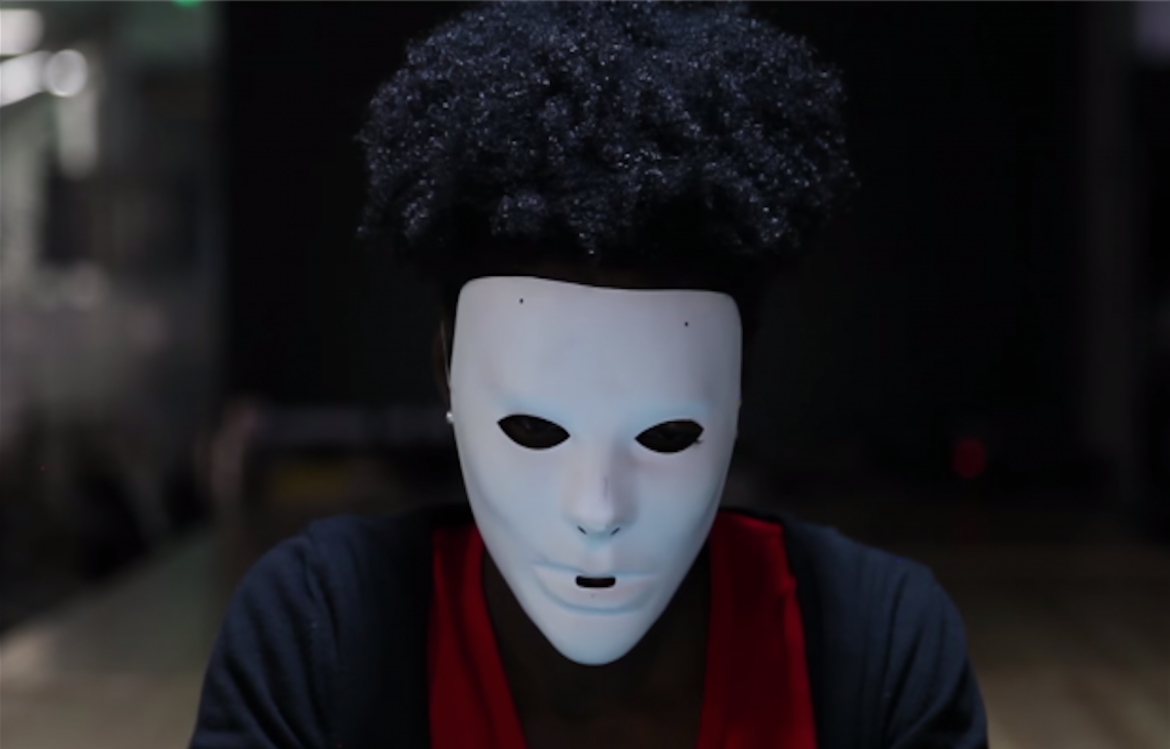

Capture d'écran de la vidéo "The Coded Gaze : Unmasking Biased Algorithms", dans laquelle Joy Buolamwini montre que son visage noir n'est pas reconnu par le logiciel, jusqu'à ce qu'elle porte un masque blanc.

Dans divers travaux, elle a montré que les systèmes de reconnaissance faciale ont du mal à détecter ou correctement identifier les visages noirs. Selon elle et d’autres experts, c’est parce qu’ils sont en grande partie conçus par des ingénieurs blancs, qui utilisent des bibliothèques logicielles elles-mêmes souvent écrites par des ingénieurs blancs. Comme tout le monde, ceux-ci ont des biais, qui se retrouvent ensuite dans le code.

Ainsi, explique Breland : « Quand le codeur conçoit l’algorithme, il va mettre en avant certains traits, qui peuvent être plus prononcés dans une race qu’une autre. Ceci peut s’expliquer par le fait que l’ingénieur utilise des recherches préexistantes sur les techniques et pratiques de la reconnaissance faciale, elles-mêmes biaisées, ou bien par ses propres expériences et représentations. Le code qui est le produit de tout ça sera orienté vers l’interprétation des visages blancs, et testé principalement sur des sujets blancs. » Même si le logiciel de reconnaissance faciale est conçu pour s’améliorer et gagner en précision avec les techniques d’apprentissage machine, cela ne changera pas grand-chose, car : « il s’entraîne souvent sur des données où ne figurent que des visages blancs. »

photo de Michael Critz - Critz, Michael. (Blogger). (2009). How Good is iPhoto Facial Recognition? Source : Wikimédia (CC BY-SA 4.0)

Un manque d’évaluation

Les agences de police qui utilisent ces logiciels de reconnaissance faciale n’évaluent presque jamais leurs biais raciaux. Rien ne les y oblige. Elles tentent aussi souvent de dissimuler qu’ils utilisent ces outils — ce que la chercheuse Clare Garvin appelle « du blanchiment de preuve » (ndlr : l’expression anglaise fait référence au blanchiment d’argent et non à la couleur de la peau). Les fabricants, eux, se défaussent en affirmant que c’est à la police de ne pas donner trop d’importance aux résultats des produits qu’ils conçoivent. Eux non plus ne sont pas légalement tenus d’évaluer les biais raciaux de leurs systèmes. Quand Brevin appelle des fabricants de logiciels pour les interroger à ce sujet, la plupart refusent de répondre. Un ingénieur, toutefois, explique qu’il s’agit d’une simple limite technique : le système aurait simplement du mal à identifier les extrêmes, les peaux très foncées autant que les peaux très claires.

Pour Ali Brevin, « Les logiciels de reconnaissance faciale soulèvent de nombreuses questions, auxquelles il faut apporter des réponses claires. Pour cela, il ne suffit pas de commander des études, même si celles-ci restent essentielles. Il faut absolument que la loi rattrape la technologie, pour que des gens comme (le suspect arrêté dans l’affaire de Jacksonville) puissent connaître les outils qui sont utilisés contre eux. Surtout, nous devons regarder de plus près qui fabrique ces algorithmes, et comment ceux-ci sont faits. »

Loi, débat public et examen du code : ces trois éléments seront essentiels pour s'assurer que la société de l'intelligence artificielle ne se traduise pas par la reproduction et l'intensification des inégalités.

Soutenez Socialter

Socialter est un média indépendant et engagé qui dépend de ses lecteurs pour continuer à informer, analyser, interroger et à se pencher sur les idées nouvelles qui peinent à émerger dans le débat public. Pour nous soutenir et découvrir nos prochaines publications, n'hésitez pas à vous abonner !

S'abonnerFaire un don